OpenAI تكشف سبب هلاوس الشات بوت وتقترح حلولًا جديدة

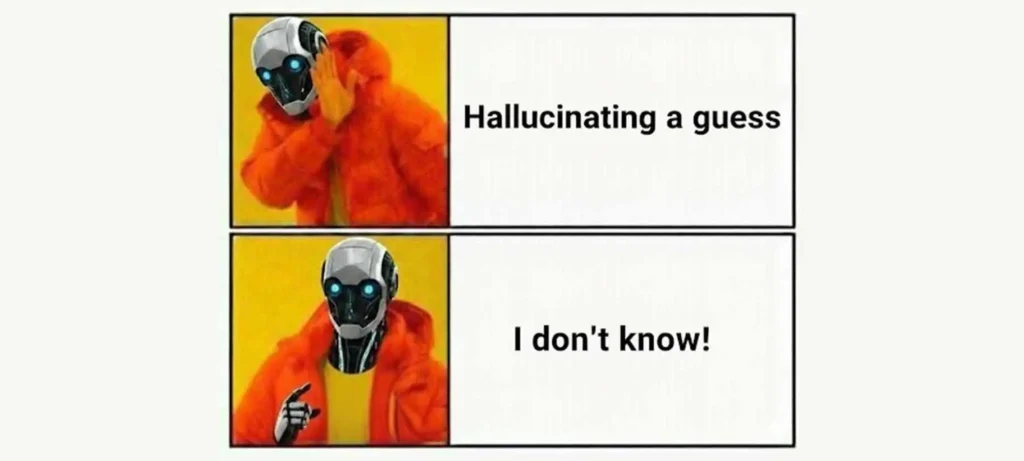

نشرت OpenAI بحثًا جديدًا يوضح أن هلاوس نماذج الذكاء الاصطناعي تعود لطرق التدريب الحالية التي تكافئ التخمين الواثق بدلًا من الاعتراف بعدم المعرفة.

تفاصيل الخبر

أظهرت دراسة حديثة من OpenAI أن هلاوس الشات بوت ليست عشوائية بل ناتجة عن أسلوب التقييم المستخدم في تدريب النماذج:

- أنظمة الذكاء الاصطناعي تحصل على نقاط كاملة عند التخمين الصحيح حتى لو كان محض صدفة.

- في المقابل، يُخصم منها كل شيء إذا أجابت “لا أعلم”.

- هذا يعزز لدى النماذج عادة التخمين دائمًا حتى في غياب أي يقين.

- اختبارات OpenAI شملت أسئلة مثل تواريخ ميلاد وأطروحات جامعية، وأظهرت أن النماذج تولد إجابات خاطئة كل مرة لكن بثقة عالية.

- الباحثون يقترحون إعادة تصميم مقاييس التقييم بحيث تعاقب الأخطاء الواثقة أكثر من إجابة “لا أعلم”.

الأهداف المستقبلية

تركز الدراسة على إعادة تعريف طريقة تطوير النماذج الذكية:

- تحسين جودة النماذج عبر مكافأة الصدق والاعتراف بعدم المعرفة.

- تقليل اعتماد النماذج على التخمين الأعمى، ما يزيد الموثوقية.

- إعداد بيئة تدريبية جديدة تسهّل تطوير أنظمة أكثر أمانًا في المهام الحساسة.

- الموازنة بين الأداء العالي والقدرة على معرفة الحدود المعرفية للنموذج.

بحث OpenAI يمثل خطوة واعدة نحو نماذج ذكاء اصطناعي أكثر صدقًا وموثوقية، حيث يصبح قول “لا أعلم” أفضل من تقديم إجابة خاطئة بثقة.