OpenAI تعترض 10 عمليات خبيثة باستخدام ChatGPT، 4 من الصين

نشرت OpenAI تقريرًا عن تعطيل 10 عمليات ضارة استُخدم فيها ChatGPT، منها 4 مرتبطة بالصين، تضمنت تضليل على وسائل التواصل والتجسس الإلكتروني.

تفاصيل الخبر

في تقرير جديد من OpenAI بعنوان “Disrupting malicious uses of AI: June 2025”، كشفت الشركة عن تعطيلها لعشرة عمليات استُخدم فيها ChatGPT لأغراض خبيثة خلال الأشهر الثلاث الماضية.

- أربع عمليات على الأقل على ارتباط بالصين، شملت:

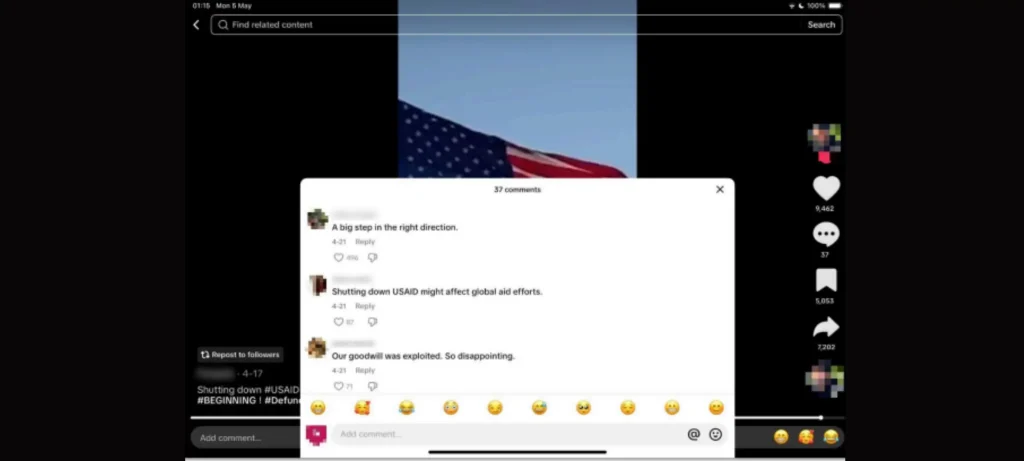

- حملة “Sneer Review” لتوليد تعليقات بالإنجليزية والصينية والأردية، ونشر مراجعات داخلية عبر منصات مثل TikTok وX وReddit وFacebook.

- عمليات تأثير متعددة المنصات تضمنت الترجمة، ابتكار شخصيات وهمية متخصصة، والتواصل مع جهات رسمية بغرض التجسس .

- عمليات أخرى تم تعطيلها تشمل:

- ممارسات من روسيا وإيران في نشر دعاية سياسية وتطوير برمجيات خبيثة.

- حملة توظيف وهمي مرتبطة بكوريا الشمالية لصياغة سير ذاتية وتأسيس حسابات مزورة للحصول على وظائف تقنية.

- عمليات خداع كمارس spam وتوظيف وهمي في كمبوديا والفلبين .

- أنواع التهديدات المكتشفة:

- تضليل اجتماعي وتعاطف سياسي.

- تطوير برمجيات ضارة متعددة المراحل.

- عمليات تجسس إلكتروني.

- عمليات استهداف وظيفي احتيالية.

- رغم أن معظم هذه العمليات لم تصل لمخرجات واسعة إلا أن طبيعتها المتنوعة ومعقدة تبرز الحاجة الملحة لتنظيم وجدية التعامل معها .

الأهداف المستقبلية

تهدف OpenAI إلى تعزيز جهود الحماية ومواجهة التحديات من خلال:

- توسيع قدرات المراقبة لتعقب سلوكيات التهديد وتمييزها مبكرًا.

- تعزيز التعاون مع شركات السوشيال ميديا ومجموعات الأمن لاكتشاف وتفكيك الشبكات الضارة سريعًا.

- نشر تقارير دورية شفافة حول تهديدات الذكاء الاصطناعي لرفع الوعي.

- تعزيز أطر التنظيم والحماية خصوصًا ضد العمليات ذات الصلة بالأنظمة الاستبدادية.

- دعم البنية التحتية للأمن الإلكتروني باستخدام الذكاء الاصطناعي لمواجهة الاختراقات المستهدفة.

يكشف هذا التقرير أن أدوات الذكاء الاصطناعي ما زالت تُستخدم في حملات تضليل وتجسس، ومن المهم أن تستمر جهات القطاع الخاص بالتعاون مع الحكومات لحماية البيئة الرقمية من هذه التهديدات.