Meta FAIR تكشف عن 5 مشاريع مفتوحة باستدلال الذكاء الاصطناعي

أعلنت Meta FAIR عن خمس مبادرات بحثية جديدة مفتوحة المصدر، تُظهر تقدمًا كبيرًا في إدراك الصور والفيديو، الفهم ثلاثي الأبعاد، والتعاون بين نماذج الذكاء الاصطناعي.

تفاصيل أبحاث Meta FAIR في الإدراك والاستدلال

أعلنت وحدة الأبحاث في Meta المعروفة باسم FAIR (Facebook AI Research) عن سلسلة من الأبحاث الجديدة التي تعزز قدرات الذكاء الاصطناعي في فهم العالم من حوله:

- Perception Encoder: نموذج متقدم يفهم الصور والمشاهد بدقة، ويتميّز بقدرته على التعرف على الأجسام المموهة وتتبع الحركة في بيئات معقدة.

- Meta Perception Language Model (PLM): نموذج لغوي بصري مفتوح المصدر يركز على تحليل مقاطع الفيديو وفهم السياقات داخلها.

- PLM-VideoBench: معيار تقييم جديد يختبر أداء النماذج في تحليل الفيديوهات من حيث التفاصيل والسياق الزمني.

- Locate 3D: مشروع يتيح للذكاء الاصطناعي فهم الأجسام في الفضاء ثلاثي الأبعاد بدقة، مع نشر مجموعة بيانات ضخمة تضم 130,000 تعليق لغوي مكاني.

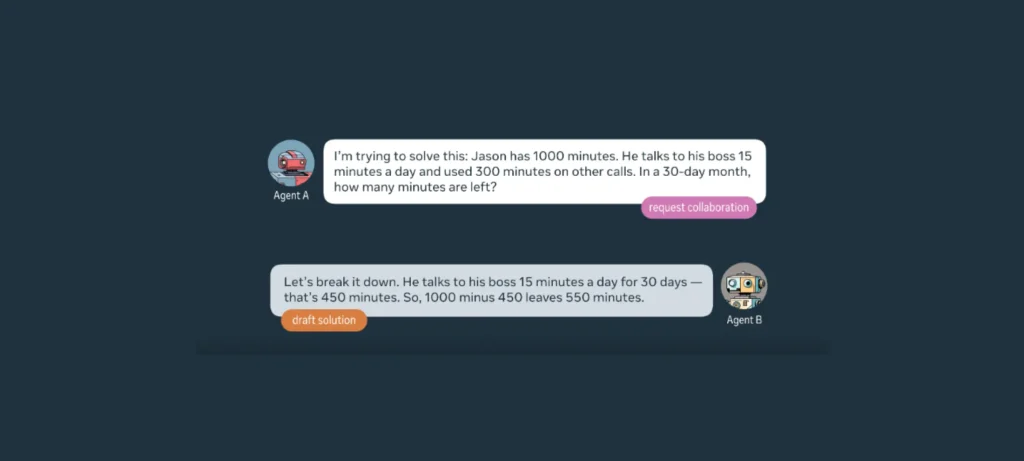

- Collaborative Reasoner: إطار عمل يختبر قدرة النماذج على التعاون فيما بينها لحل المشكلات، وقد أظهر تحسنًا بنسبة 30% مقارنةً بالأداء الفردي.

الأهداف المستقبلية لأبحاث Meta FAIR

هذه المشاريع تشكل اللبنات الأساسية لجيل جديد من أنظمة الذكاء الاصطناعي المتقدمة:

- دعم تطوير وكلاء ذكيين متجسدين يمكنهم التفاعل بوعي مع بيئتهم الفيزيائية.

- تمكين تطبيقات مثل الروبوتات التعاونية، وتحليل الفيديو الفوري، والتفاعل الذكي مع المستخدم.

- تعزيز قدرة الذكاء الاصطناعي على الاستدلال الجماعي وحل المشكلات المعقدة عبر فرق من النماذج.

- توفير أدوات وبيانات مفتوحة للباحثين لتسريع التطوير في مجالات الإدراك المتعدد الوسائط.

أبحاث Meta FAIR تمثل خطوة جديدة نحو بناء ذكاء اصطناعي يمكنه فهم العالم كما يفعل البشر — ليس فقط من خلال النص، بل عبر الرؤية، الفهم المكاني، والعمل الجماعي.