باحثو الذكاء الاصطناعي يدعون لشفافية في سلاسل التفكير

ورقة بحثية جديدة تجمع باحثين من كبرى المؤسسات مثل OpenAI وDeepMind تدعو لدراسة أعمق لتتبع سلاسل التفكير في النماذج لضمان الأمان والشفافية.

تفاصيل الخبر

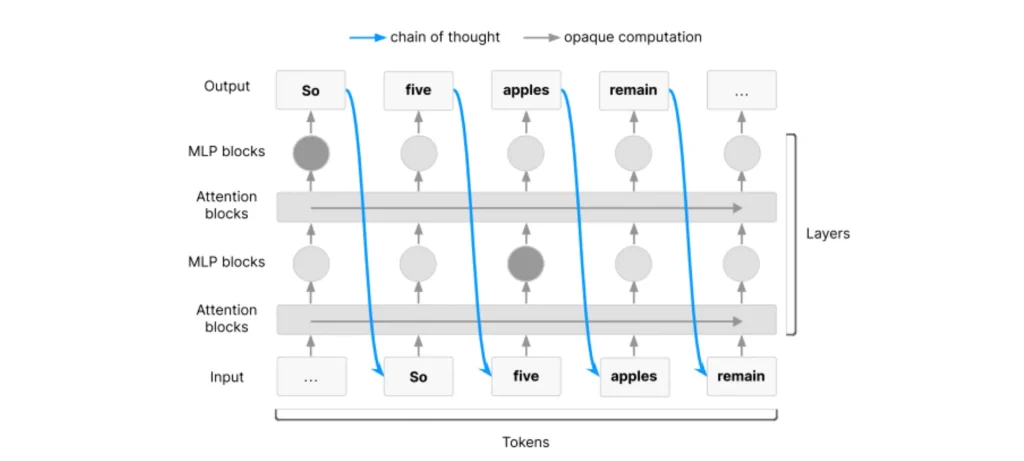

في خطوة نادرة من الإجماع بين كبرى شركات الذكاء الاصطناعي، نشر باحثون من OpenAI و DeepMind و Anthropic وغيرهم ورقة علمية تدعو لمراقبة أفضل لما يُعرف بـ سلاسل التفكير (Chain-of-Thought) في النماذج.

- الورقة تسلط الضوء على أن آثار التفكير خطوة بخطوة تُعد نافذة فريدة لفهم كيفية اتخاذ النماذج لقراراتها.

- الباحثون يحذرون من أن شفافية النماذج قد تتراجع مع تطور تقنيات التدريب وتغيّر أساليب التطوير.

- من الأسماء البارزة في التوقيع: مارك تشين من OpenAI، و إيليا سوتسكيفر من SSI، و جيفري هينتون الحائز على نوبل، و شاين ليغ من DeepMind.

- يقترحون إنشاء تقييمات قياسية للقدرة على المراقبة وإدراج هذه التقييمات في قرارات نشر النماذج المتقدمة.

الأهداف المستقبلية

يسعى الباحثون من خلال هذه المبادرة إلى:

- ضمان الشفافية في نماذج التفكير المتقدمة.

- تطوير أدوات مراقبة تُساعد في فهم مسارات القرار.

- تقليل المخاطر عبر تقييمات واضحة قبل نشر النماذج.

- الحفاظ على نافذة الفهم قبل أن تُغلقها المنافسة الشديدة.

هذه الدعوة تمثل لحظة حاسمة في صناعة الذكاء الاصطناعي، حيث يمكننا اليوم مراقبة خطوات النماذج الداخلية، لكن الحفاظ على هذه القدرة يتطلب عملًا جماعيًا وتعاونًا دوليًا.