رسالة مفتوحة تطالب بوقف تطوير الذكاء الاصطناعي الفائق (ASI)

أطلق معهد Future of Life Institute رسالة مفتوحة وقعها عدد من الشخصيات البارزة في مجالي التكنولوجيا والسياسة، تطالب الحكومات بإيقاف تطوير الذكاء الاصطناعي الفائق (ASI) حتى يتم التأكد من إمكانية السيطرة عليه وموافقة الجمهور على إنشائه.

تفاصيل الخبر

الرسالة الجديدة أثارت جدلاً واسعًا في الأوساط التقنية، إذ عبّرت عن مخاوف متزايدة بشأن مخاطر التقدّم السريع في تطوير أنظمة الذكاء الاصطناعي الفائق (ASI) المتقدمة.

- أبرز المخاوف: أشارت الرسالة إلى خطر “انقراض البشرية”، و”فقدان الحريات والكرامة”، و”انعدام السيطرة البشرية على الأنظمة الذكية”، إلى جانب القلق من “انتهاء دور الإنسان الاقتصادي”.

- غياب الكبار: لم يشارك في التوقيع قادة شركات الذكاء الاصطناعي الكبرى مثل OpenAI وGoogle وAnthropic وxAI وMeta، بينما وقّع عليها موظف حالي في OpenAI هو Leo Gao.

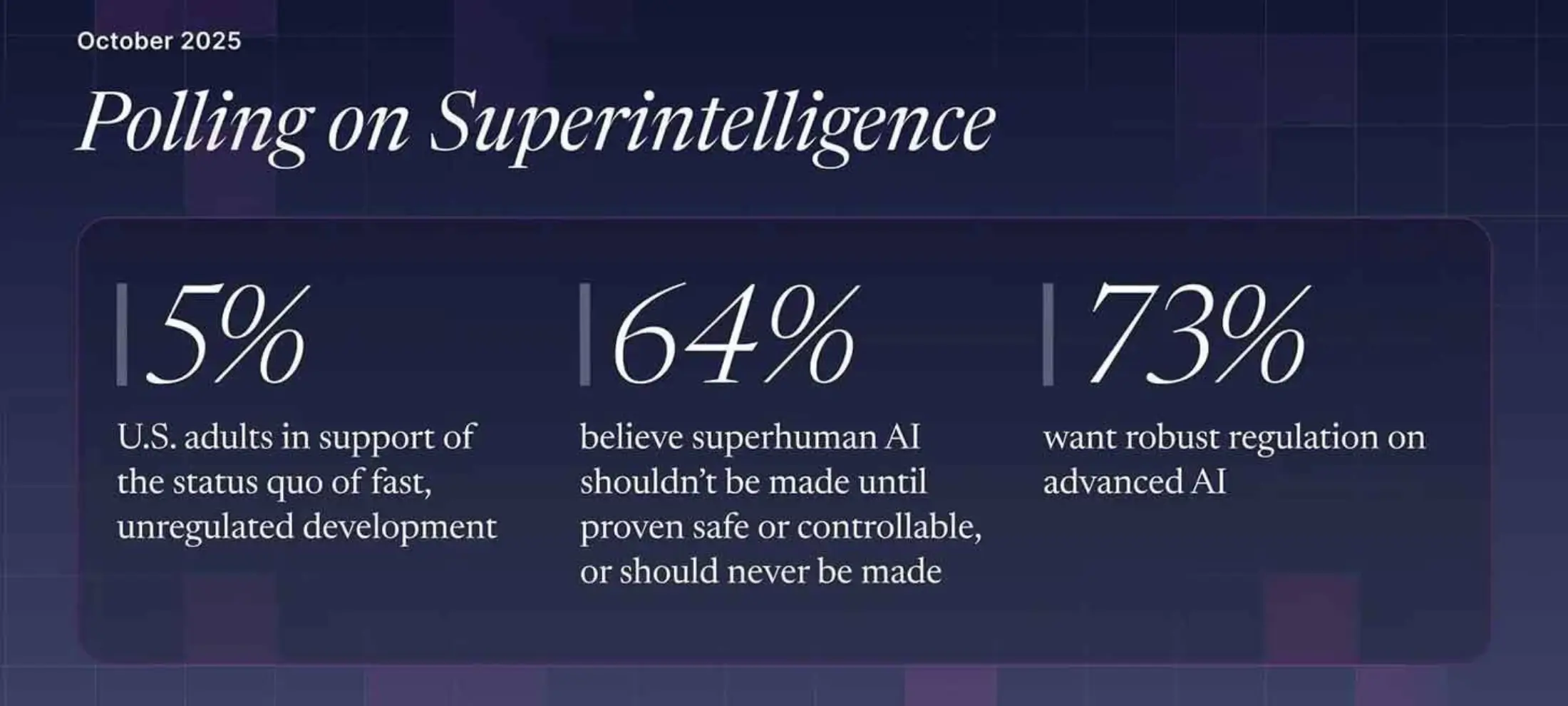

- نتائج استطلاع: أظهر المعهد أن 64% من الأمريكيين يرغبون في وقف تطوير ASI حتى يثبت أنه آمن، في حين يؤيد فقط 5% استمرار التطوير دون قيود.

- أسماء لامعة: من أبرز الموقّعين “آباء الذكاء الاصطناعي” Yoshua Bengio وGeoffrey Hinton، إلى جانب Steve Wozniak مؤسس Apple المشارك، وRichard Branson مؤسس Virgin.

الأهداف المستقبلية

تهدف هذه الدعوة لإيقاف الذكاء الاصطناعي الفائق (ASI) إلى:

- دفع الحكومات لوضع تشريعات صارمة قبل السماح بتطوير الذكاء الاصطناعي الفائق.

- ضمان الشفافية والمساءلة في مراحل البحث والتطوير.

- إشراك الجمهور والمجتمع العلمي في القرارات المتعلقة بإطلاق أنظمة ذكاء تتجاوز القدرات البشرية.

- تشجيع التعاون الدولي لضمان أمن البشرية في مواجهة أنظمة يصعب التحكم فيها.

رغم أن هذه ليست المرة الأولى التي تُثار فيها دعوات لوقف تسارع تطوير الذكاء الاصطناعي الفائق (ASI)، إلا أن لهجة التحذير هذه المرة تبدو أكثر حدة، ما يعكس تزايد القلق العالمي من الوصول إلى مرحلة تتفوق فيها الآلات على الإنسان في الوعي والسيطرة.