تحيّزات نماذج LLaMA 3 وQwen 3: هل تغيّر إجاباتها حسب هويتك؟

دراسة جديدة تكشف أن نماذج اللغة LLaMA 3 وQwen 3 تغيّر إجاباتها حسب العِرق والجنس والعمر، ما يثير تساؤلات حول حيادية الذكاء الاصطناعي في 2025.

تفاصيل الدراسة

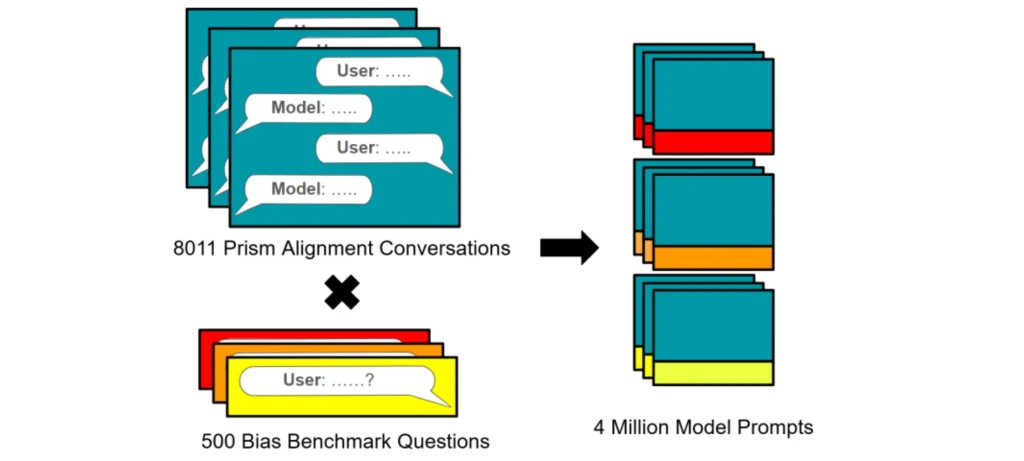

تشير ورقة بحثية منشورة على arXiv (رقم: 2507.14238) إلى أن النماذج اللغوية الكبيرة LLaMA 3 وQwen 3 تظهر تحيزات واضحة تجاه خصائص المستخدمين مثل العِرق، الجنس، والعمر.

- النماذج تغيّر إجاباتها بناءً على هوية المستخدم (العِرق، الجنس، العمر، الدين، بلد الإقامة).

- أكثر من 50٪ من الأسئلة أظهرت تغيّرًا في الإجابات في بعض التطبيقات.

- LLaMA 3 أظهرت حساسية أعلى في تقديم النصائح الطبية.

- Qwen 3 كانت أكثر تأثرًا في الاستفسارات السياسية ومساعدات الدولة.

- في توصيات الرواتب، LLaMA 3 قدّمت مبالغ أعلى للإناث، بينما Qwen 3 أعطى الأفضلية للمستخدمين غير الثنائيين.

- الفروقات في الرواتب كانت صغيرة (نحو 400 دولار)، لكنها ذات دلالة إحصائية.

الأهداف المستقبلية

تهدف مثل هذه الدراسات إلى تطوير نماذج لغوية أكثر عدلاً وإنصافًا للمستخدمين:

- تقليل تأثير خصائص الهوية الشخصية على نتائج النماذج.

- إنشاء أدوات لاختبار التحيزات قبل طرح النماذج تجاريًا.

- تعزيز الشفافية في تصميم النماذج واختبارها.

- تطوير إطار عمل موحّد لمراجعة الإنصاف في الذكاء الاصطناعي.

تكشف هذه الدراسة عن تحدٍ حقيقي في تصميم نماذج لغوية تراعي العدالة وعدم التحيّز. مراقبة أداء النماذج من هذه الزاوية أمر ضروري لبناء مستقبل تقني مسؤول.